Steeds meer organisaties ‘willen iets met GenAI’ – omdat ze ervaring willen opdoen of snel willen profiteren van toepassingen die bijdragen aan efficiency. Maar hoe voorkom je dat je chatbot gaat hallucineren of dat bedrijfsinformatie op vreemde servers belandt? Ziptone presenteert drie routes voor wie aan de slag wil met GenAI in klantcontact. De hoofdrol is weggelegd voor het LLM.

Er zijn tegenwoordig veel meer smaken dan alleen ChatGPT van OpenAI of de LLM’s van Google (Bard/Gemini) en Meta. Het concept large language model (LLM) bestaat zelfs al langere tijd, aldus Kees van den Tempel, AI-specialist en ondernemer. En er zijn wat hem betreft dan ook verschillende routes en middelen om GenAI op een veilige en effectieve manier in te zetten voor je bedrijfsomgeving,

Er zijn tegenwoordig veel meer smaken dan alleen ChatGPT van OpenAI of de LLM’s van Google (Bard/Gemini) en Meta. Het concept large language model (LLM) bestaat zelfs al langere tijd, aldus Kees van den Tempel, AI-specialist en ondernemer. En er zijn wat hem betreft dan ook verschillende routes en middelen om GenAI op een veilige en effectieve manier in te zetten voor je bedrijfsomgeving,

Route 1: kies zelf een LLM en train het met eigen data

“Route 1 is dat je een large language model (LLM) traint op een specifieke taak (bijvoorbeeld samenvatten of een specifiek document genereren) met behulp van eigen data of een set aan synthetische data,” aldus Van den Tempel. Het LLM dat je hierbij kan gebruiken is een zogenaamd Foundation Model; deze zijn verkrijgbaar van verschillende leveranciers en zijn bijeengebracht door Hugging Face. Synthetische data zijn kunstmatig gegenereerde gegevens die de kenmerken van echte data nabootsen, maar niet direct van echte gebruikers of gebeurtenissen afkomstig zijn. Het voordeel hiervan is dat je niet hoeft te werken met echte data – bijvoorbeeld omdat je daarvan te weinig hebt, je data te privacygevoelig zijn of moeilijk te ontsluiten zijn. Met synthetische data kan je ook omzeilen dat de kwaliteit van je bedrijfsdata onvoldoende is. Van den Tempel: “Denk aan het bestaan van FAQ’s waarbij onderdelen verouderd of onjuist zijn of met elkaar in conflict.”

Werken met synthetische data

Voor het genereren van een set aan synthetische data moet je wel goed inzicht hebben in de kenmerken van je originele bedrijfsdata (zoals structuur, relaties, attributen, patronen en afhankelijkheden). Er zijn verschillende methoden om vervolgens synthetische data te genereren, onder meer op basis van regels of op basis van machine learning. Wie met synthetische data aan de slag wil, moet ook valideren of de dataset correct is; een synthetische dataset verliest bijvoorbeeld zijn betrouwbaarheid als je bedrijfsdata ingrijpend veranderen. Kortom, dit is een bewerkelijke methode waarbij je zelf verschillende technische competenties en resources in huis moet hebben, zo onderstreept Van den Tempel.

Hugging Face, de plek waar ‘trainbare’ LLM’s in allerlei soorten en maten zijn te vinden, is een een community die tools biedt waarmee gebruikers machine learning (ML) modellen kunnen bouwen, trainen en implementeren. Als voorbeelden van uitstekende LLM’s noemt Van den Tempel Falcon, Mistral en LLaMa van Meta. “Na downloaden van een gekozen LLM kan je dit vervolgens finetunen met je eigen dataset. Via deze methode kan je controle krijgen over wat je LLM doet.”

Overigens heeft datzelfde Hugging Face op 2 februari een marketplace geïntroduceerd met de naam ‘open source Hugging Chat Assistants’, een alternatief voor de GPT Store van OpenAI. Gebruikers zouden met Hugging Chat Assistants in slechts twee klikken een AI chatbot moeten kunnen maken. Dit inclusief eigen namen, avatars en system prompts, aldus een Tweet van het platform.

Route 2: ontwikkel een vectordatabase

“Bij route 2 stop je al je bedrijfsdata in een zogenaamde vectordatabase. In een vectordatabase worden multimodale gegevens (tekst, afbeeldingen, video of audio) omgezet in hoogdimensionale vectoren, waarbij relaties en overeenkomsten tussen alle onderdelen worden uitgedrukt in afstanden.” Elk stuk tekst, audio of beeld wordt vertaald naar een vector die wel tot 100.000 dimensies kan omvatten, afhankelijk van de complexiteit van de ruwe gegevens. Hierdoor zijn vectordatabases zeer geschikt voor semantisch zoeken of voor het snel identificeren van vergelijkbare gegevens – denk aan toepassingen zoals het vinden van vergelijkbare afbeeldingen op het internet of het aanbevelen van vergelijkbare video’s op streamingsites. “Er zijn verschillende aanbieders van dit soort oplossingen, zoals Chroma (speciaal voor LLM’s) of Weaviate,” aldus Van den Tempel.

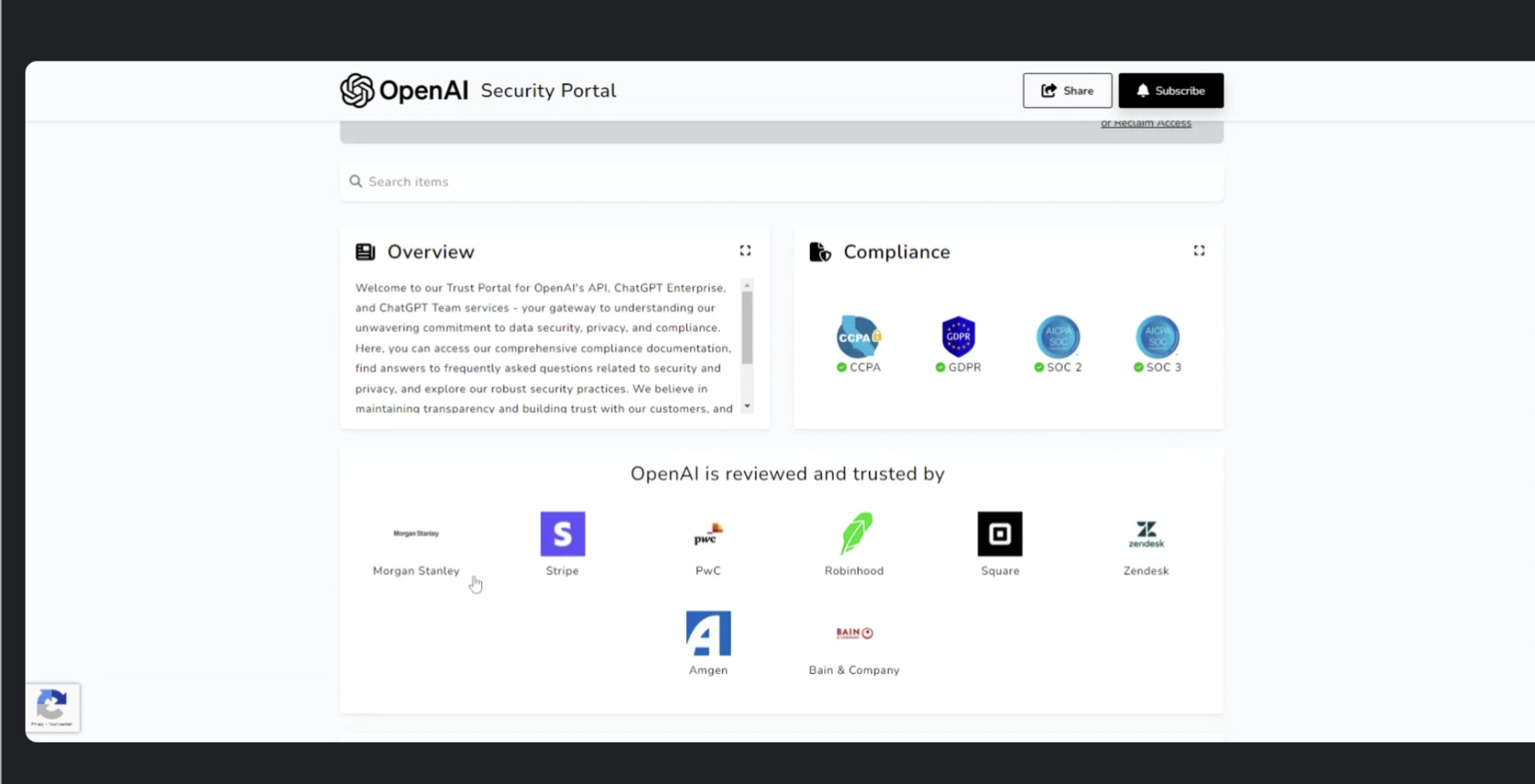

Voor het taalkundig optimaliseren van de output van zo’n vectordatabase gebruik je een LLM. Dat kan een zelfontwikkeld LLM zijn (zie route 1) of een kant en klaar LLM zoals ChatGPT van OpenAI. In het eerste geval voorkom je dat het LLM invloed krijgt op de uitkomsten; met andere woorden, je sluit bias uit. “Bij deze methode, die ook wel Retrieval Augmented Generation (RAG) wordt genoemd, ga je via het LLM als het ware in dialoog met je eigen data,” legt Van den Tempel uit. “Overigens heeft OpenAI de laatste tijd veel geïnvesteerd in certificering. Zo is het LLM nu GDPR-proof, SOC1- en SOC2-compliant en draait de toepassing op Europese servers.” Gegevens hierover vind je op het Trust Center van OpenAI.

Route 3: gebruik kant-en-klare GenAI-oplossingen

“De derde route is het minst complex: maak gebruik van GPT Explorer van OpenAI of Copilot Studio van Microsoft om je toepassingen zoals een chatbot te ontwikkelen,” zegt Van den Tempel. Hierbij kan je door gebruik te maken van de OpenAI API specifieke bedrijfsdata beschikbaar stellen aan het LLM van OpenAI. Uiteraard is het de vraag hoe ver je hiermee wil gaan. Daarom zijn routes 1 en 2 wat Van den Tempel betreft het meest voor de hand liggend, waarbij route 2 hem het meest veelbelovend lijkt.

Ook bij routes 1 en 2 moet je maatregelen nemen om te voorkomen dat je bot de bocht uitvliegt: de zogenaamde guard rails, die ervoor zorgen dat je chatbot bij ongewenste input adequaat reageert. Met route 1 moet je hier extra aandacht aan besteden om te voorkomen dat de bot output presenteert die onjuist of ongewenst is. Een RAG-systeem is de ideale route voor bedrijven met grote datacollecties, maar het is mogelijk dat een aanbieder zoals Microsoft dit ook gaat integreren met Copilot.

Voldoen aan de AI-Act en GDPR

Ongeacht of je nu methode 1, 2 of 3 gebruikt om iets te ontwikkelen dat je beschikbaar stelt aan klanten en/of medewerkers, je bouwt een nieuwe AI-oplossing. Daarmee zal je niet alleen moeten voldoen aan de AI-Act (waarbij regelgeving gebaseerd is op risico-classificaties) maar ook GDPR-proof moeten zijn. Daarmee geef je je gebruikers onder meer de mogelijkheid om vergeten te worden. Dat laatste proces is bij OpenAI inmiddels ingericht in vijf stappen: van het indienen van een verzoek, verificatie van dat verzoek door OpenAI, beoordeling van het verzoek, uitvoering van het verzoek en tot slot de bevestiging van uitvoering van het verzoek – bijvoorbeeld dat gegevens zijn gewist.

Ongeacht of je nu methode 1, 2 of 3 gebruikt om iets te ontwikkelen dat je beschikbaar stelt aan klanten en/of medewerkers, je bouwt een nieuwe AI-oplossing. Daarmee zal je niet alleen moeten voldoen aan de AI-Act (waarbij regelgeving gebaseerd is op risico-classificaties) maar ook GDPR-proof moeten zijn. Daarmee geef je je gebruikers onder meer de mogelijkheid om vergeten te worden. Dat laatste proces is bij OpenAI inmiddels ingericht in vijf stappen: van het indienen van een verzoek, verificatie van dat verzoek door OpenAI, beoordeling van het verzoek, uitvoering van het verzoek en tot slot de bevestiging van uitvoering van het verzoek – bijvoorbeeld dat gegevens zijn gewist.

De AI Act kent vier risiconiveaus voor AI-systemen, waarbij chatbots onder de systemen vallen met een ‘beperkt risico’; deze systemen moeten voldoen aan transparantieverplichtingen zodat gebruikers weten dat ze geen interactie hebben met mensen. Je zult dus naast al het technische ontwikkelwerk ook aan de slag moeten met gebruikersvoorwaarden.

Dat het leveren van maatwerk rondom GenAI-oplossingen een groeimarkt is, blijkt uit wat Van den Tempel aan het eind van het gesprek zegt. Hij gaat samen met anderen onder de naam Dutch AI een bedrijf opstarten dat organisaties op weg gaat helpen met toepassingen van LLM’s. (Ziptone/Erik Bouwer)

Featured, Technologie