Twee jaar geleden introduceerde Pegasystems de T-Switch – een schakelaar waarmee je kunt kiezen voor de toepassing van wel of niet uitlegbare algoritmen in je Pega-omgeving. Dit jaar ging Rob Walker (VP Decision Management & Analytics, Pegasystems) tijdens Pegaworld2019 opnieuw in op de steeds grotere rol van kunstmatige intelligentie (AI) in marketing, sales en service. Hoe houden we zicht op de wijze waarop AI ons leven als consument bepaalt?

De aandacht voor de ethische kant van AI neemt toe: hoe weten we zeker dat kunstmatige intelligentie de juiste beslissingen neemt? Bekend dilemma is dat van de zelfrijdende auto die morele afwegingen moet maken. Een tweede probleem is bias, dat in 2016 door onderzoekers werd beschreven. Zij lieten Word2vec, een machine learning oplossing voor de verwerking van tekst, zoeken naar onderling gerelateerde begrippen. Ze gebruikten Google News als bron en kwamen op relaties als ‘vader-dokter’, wat Word2vec beantwoordde met een ‘vergelijkbare’ relatie als ‘moeder-verpleegster’. In de bronnen die Google News gebruikt, lijkt dus een bias te zitten – slecht nieuws voor de techwereld die wel wat diversiteit kan gebruiken, aldus Walker.

De aandacht voor de ethische kant van AI neemt toe: hoe weten we zeker dat kunstmatige intelligentie de juiste beslissingen neemt? Bekend dilemma is dat van de zelfrijdende auto die morele afwegingen moet maken. Een tweede probleem is bias, dat in 2016 door onderzoekers werd beschreven. Zij lieten Word2vec, een machine learning oplossing voor de verwerking van tekst, zoeken naar onderling gerelateerde begrippen. Ze gebruikten Google News als bron en kwamen op relaties als ‘vader-dokter’, wat Word2vec beantwoordde met een ‘vergelijkbare’ relatie als ‘moeder-verpleegster’. In de bronnen die Google News gebruikt, lijkt dus een bias te zitten – slecht nieuws voor de techwereld die wel wat diversiteit kan gebruiken, aldus Walker.

AI kan ons gemakkelijk misleiden

AI is al een tijdje in staat om fake Rembrandts te maken, maar ook portretfoto’s van mensen die niet bestaan, en die niet van echt zijn te onderscheiden. Walker hield zijn publiek ook de vraag voor wat er gebeurt als in een algoritme is ingebouwd dat het zich moet ontwikkelen door zelfstandig delen over te nemen van andere algoritmen.

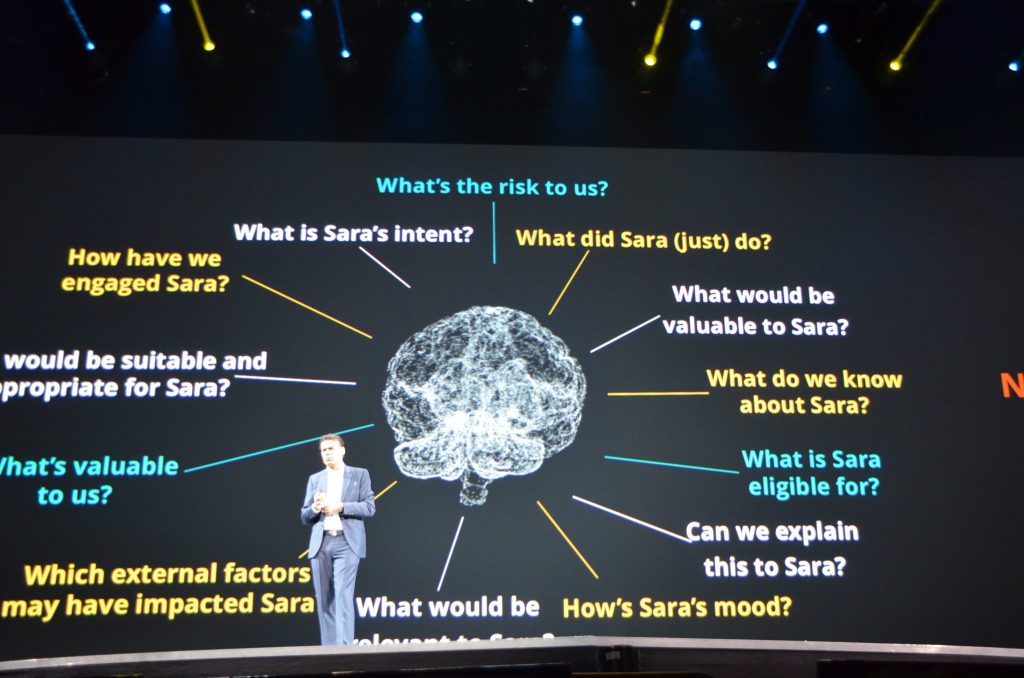

Niet alle AI-toepassingen worden echter ontwikkeld om levensbepalende beslissingen te nemen. AI kan ook een rol spelen in de manier waarop bedrijven zaken doen met hun klanten. Maar ook hier zal steeds vaker gelden dat er ethische beslissingen moeten worden genomen. Welke context wordt wel en niet meegenomen in het accepteren van een klant of het doen van een passend aanbod? Ongeacht wie een algoritme ontwikkelt (mens of machine): algoritmen zouden eerlijk uitlegbaar, robuust en herleidbaar moeten zijn, stelde Walker; alleen dan kan je bouwen aan uitkomsten die vertrouwd worden.

Welke opbrengst moet Next Best Action opleveren?

Verderop in zijn verhaal legde Walker de link met winstgevendheid: een next best action, gegeneerd door AI, kan leiden tot een maximale opbrengst. Maar wat als klanten daardoor mogelijk in de problemen komen? In de visie van Walker is winstmaximalisatie vrijwel nooit empathisch; een empathisch bedrijf kiest voor de relatie waarin de context van de klant wordt meegenomen. Die context bevat vele factoren, waaronder timing en situatie – zo is het weinig invoelend als je iemand wiens huis in brand staat, benadert voor een nieuw hypotheekaanbod.

Bedrijven zijn echter ook geen liefdadigheidsinstellingen, dus AI zal wat Walker betreft op zoek moeten naar de juiste balans. Hiertoe introduceert Pega eind 2019 de Customer Empathy Advisor, onderdeel van de Pega Decision Hub. Dit is een regelaar, net als de T-Switch, die laat zien wat de financiële en empathische effecten zijn van een mogelijke beslissing. Een beslissing zal bijvoorbeeld weinig empathisch uitpakken wanneer nauwelijks rekening is gehouden met de context van de klant. Niet alleen de vraag of een aanbod past bij de situatie van de klant, maar ook de mate waarin een bedrijf kiest voor relevantie, is bepalend voor de opportuniteitskosten: de opbrengsten van een niet gekozen alternatief. Simpel gezegd: zet je in op een harde product push of neem je genoegen met een iets lagere opbrengst met een aanbod dat beter aansluit op de situatie van de klant? Empathie en relevantie hebben dus een link met duurzame bedrijfsvoering.

‘Made by AI’

Klantcontact.nl vroeg Walker na afloop van zijn keynote hoe organisaties in de praktijk gaan zorgen dat hun door AI-aangedreven acties op het gebied van upselling en cross selling via digitale kanalen niet de bocht uitvliegen. “Grote bedrijven hebben vaak een compliance officer. Daar gaat geen algoritme live voordat het geïnspecteerd is,” stelt Walker. “Vaak is in beleid vastgelegd welke modellen gebruikt mogen worden – bijvoorbeeld geen complexe neurale netwerken in het proces van kredietacceptatie. Daarnaast worden met name in de financiële sector alle elementen van een voorstel of transactie vastgelegd: de onderliggende logica, de gebruikte data waarop een voorstel is gebaseerd en de ontvangen reactie van de klant. Auditors kunnen dat dus analyseren. Neurale netwerken zullen eerder worden ingezet voor creatieve marketingdoeleinden: wat is de beste bannerfoto bij een specifieke webbezoeker? Grote kans dat je zo’n soort beslissing niet goed kunt uitleggen.”

Consumenten zullen steeds vaker te maken krijgen – ook zonder het te weten – met adviezen, tips en aanbiedingen die via een algoritme gecreëerd door AI, tot stand zijn gekomen. Het wordt in de ogen van Walker dan ook steeds moeilijker om het onderscheid te blijven zien met door mensen genomen beslissingen. Het zou wat hem betreft geen slecht idee zijn om kunstmatig genomen beslissingen van een label te voorzien. Wie weet vinden we binnenkort bij onze online aanbieding de melding ‘dit voorstel is gegenereerd door kunstmatige intelligentie’.

Tekst en beeld: Erik Bouwer

Featured, Technologie